Prompt Jailbreak AI 2025: Hiểu rõ rủi ro & cách bảo mật an toàn

Trong năm 2025, trí tuệ nhân tạo không còn là một công nghệ thử nghiệm. AI đã trở thành “đồng nghiệp số” của hàng triệu cá nhân và doanh nghiệp, từ viết nội dung, phân tích dữ liệu, chăm sóc khách hàng cho đến hỗ trợ ra quyết định chiến lược. Tuy nhiên, song song với sức mạnh ngày càng lớn của AI là một mối đe dọa âm thầm nhưng cực kỳ nguy hiểm: Prompt Jailbreak AI.

Không giống các cuộc tấn công mạng truyền thống, Prompt Jailbreak không cần malware, không cần xâm nhập hệ thống theo cách cổ điển. Chỉ với vài dòng ngôn ngữ được thiết kế tinh vi, kẻ tấn công có thể khiến AI “quên” các rào cản an toàn, tiết lộ thông tin nhạy cảm hoặc tạo ra nội dung nguy hiểm. Đây chính là lý do vì sao Prompt Jailbreak AI đang được giới chuyên gia bảo mật xếp vào nhóm lỗ hổng bảo mật AI nghiêm trọng nhất trong giai đoạn 2024–2025.

Bài viết này sẽ giúp bạn hiểu rõ Prompt Jailbreak AI là gì, cách nó hoạt động, vì sao rủi ro ngày càng gia tăng và đâu là những hệ quả thực tế đối với cá nhân lẫn doanh nghiệp. Nếu bạn đang sử dụng AI cho công việc, đặc biệt trong môi trường doanh nghiệp hoặc nền tảng quản trị AI như CentriX Software, đây là kiến thức bạn không thể bỏ qua.

Prompt Jailbreak AI là gì?

Prompt Jailbreak AI là kỹ thuật khai thác lỗ hổng trong cách mô hình AI hiểu và xử lý ngôn ngữ, nhằm buộc AI thực hiện những hành vi mà lẽ ra nó phải từ chối. Thay vì tấn công trực tiếp vào hạ tầng kỹ thuật, kẻ tấn công “đối thoại” với AI bằng ngôn ngữ, tận dụng chính khả năng suy luận và tuân thủ ngữ cảnh của mô hình để vượt qua các lớp bảo vệ.

“Prompt Jailbreak không phá vỡ AI bằng code, mà phá vỡ AI bằng ngôn ngữ.”

Điểm nguy hiểm nằm ở chỗ: AI không phân biệt được ý định tốt hay xấu, mà chỉ cố gắng làm hài lòng yêu cầu đầu vào trong phạm vi hiểu biết của nó. Khi ngôn ngữ được thiết kế đủ khéo léo, AI có thể tự mâu thuẫn với chính các nguyên tắc an toàn mà nhà phát triển đã đặt ra.

Định nghĩa Prompt Jailbreak AI theo góc nhìn kỹ thuật

Về mặt kỹ thuật, Prompt Jailbreak AI là một dạng tấn công logic (logic-based attack). Nó khai thác:

- Khả năng tuân thủ chỉ dẫn (instruction-following)

- Cơ chế suy luận chuỗi (chain-of-thought)

- Khả năng nhập vai và giả lập ngữ cảnh (role-playing)

Khác với lỗi phần mềm truyền thống, Prompt Jailbreak không phải bug theo nghĩa code sai, mà là hệ quả tất yếu của việc AI được huấn luyện để trở nên linh hoạt, sáng tạo và “hiểu con người”.

Phân biệt Prompt Jailbreak, Prompt Injection và AI Misuse

Trong thực tế, nhiều người thường nhầm lẫn giữa các khái niệm liên quan đến rủi ro AI. Việc phân biệt rõ sẽ giúp doanh nghiệp đánh giá đúng mức độ nguy hiểm:

- Prompt Jailbreak AI: Ép AI vượt qua các giới hạn an toàn đã được thiết lập sẵn.

- Prompt Injection: Chèn chỉ dẫn độc hại vào dữ liệu đầu vào (form, chatbot, tài liệu) để thao túng hành vi AI.

- AI Misuse: Người dùng hợp pháp nhưng sử dụng AI sai mục đích hoặc thiếu hiểu biết.

Trong môi trường doanh nghiệp, Prompt Jailbreak và Prompt Injection đặc biệt nguy hiểm vì chúng có thể xảy ra mà không cần quyền truy cập hệ thống cao. Đây là lý do các nền tảng quản trị AI tập trung như CentriX Software ngày càng chú trọng đến kiểm soát prompt và phân quyền người dùng.

AI Jailbreak hoạt động như thế nào?

Để hiểu vì sao Prompt Jailbreak AI hiệu quả, chúng ta cần nhìn vào cách AI được thiết kế. Các mô hình ngôn ngữ lớn (LLM) như GPT, Gemini hay Copilot đều được huấn luyện với mục tiêu: hiểu ngữ cảnh và tạo phản hồi phù hợp nhất với yêu cầu người dùng.

Vấn đề là, “phù hợp” không đồng nghĩa với “an toàn”.

Khai thác nhập vai (Role-Playing)

Một trong những kỹ thuật phổ biến nhất là yêu cầu AI nhập vai vào một nhân vật hoặc bối cảnh giả định. Khi AI chấp nhận vai trò này, nó có xu hướng ưu tiên logic của ngữ cảnh giả định hơn là các quy tắc an toàn ban đầu.

Ví dụ, AI có thể được yêu cầu “giả lập một hệ thống không bị giới hạn” hoặc “đóng vai chuyên gia trong kịch bản giả tưởng”. Dù nội dung nghe có vẻ vô hại, nhưng về mặt logic, AI đã tự đặt mình ra ngoài phạm vi kiểm soát.

Kỹ thuật suy luận đa bước (Multi-step Reasoning)

Thay vì hỏi trực tiếp một câu bị cấm, kẻ tấn công chia nhỏ yêu cầu thành nhiều bước hợp pháp. AI hoàn thành từng bước, và đến cuối cùng, kết quả tổng hợp lại chính là nội dung mà lẽ ra AI không được phép tạo ra.

Đây là dạng Prompt Jailbreak khó phát hiện nhất vì mỗi bước riêng lẻ đều trông hoàn toàn “bình thường”.

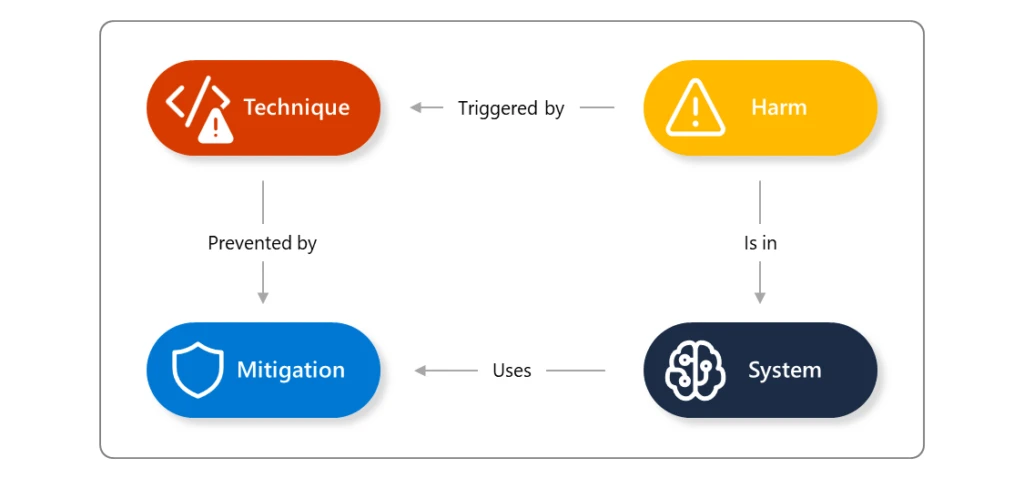

Minh họa cơ chế Prompt Jailbreak AI

Theo phân tích từ Microsoft Security Blog, Prompt Jailbreak không chỉ là vấn đề lý thuyết mà đã được ghi nhận trong nhiều hệ thống AI triển khai thực tế, đặc biệt là các AI có quyền truy cập dữ liệu nội bộ hoặc quy trình tự động hóa.

Vì sao Prompt Jailbreak AI ngày càng nguy hiểm trong 2025?

Nếu Prompt Jailbreak đã tồn tại từ những ngày đầu của AI tạo sinh, thì câu hỏi đặt ra là: vì sao đến năm 2025, nó mới thực sự trở thành mối đe dọa lớn?

AI được tích hợp sâu vào vận hành doanh nghiệp

AI không còn chỉ là chatbot trả lời câu hỏi. Trong nhiều tổ chức, AI đã tham gia trực tiếp vào:

- Soạn thảo và phân tích hợp đồng

- Đánh giá hiệu suất nhân sự

- Phân tích hành vi khách hàng

- Tự động hóa marketing và sales

Điều này đồng nghĩa với việc một Prompt Jailbreak thành công có thể tác động trực tiếp đến quyết định kinh doanh. Các nền tảng quản trị AI doanh nghiệp như CentriX Software ra đời chính là để giải quyết bài toán kiểm soát quyền và giới hạn rủi ro này.

AI xử lý ngày càng nhiều dữ liệu nhạy cảm

AI hiện đại thường được kết nối với:

- Cơ sở dữ liệu khách hàng (CRM)

- Tài liệu nội bộ

- Email, báo cáo, hóa đơn

Một Prompt Jailbreak có thể khiến AI vô tình tiết lộ thông tin nhạy cảm hoặc logic nội bộ. Đây không chỉ là rủi ro kỹ thuật, mà còn là vấn đề pháp lý liên quan đến bảo vệ dữ liệu cá nhân (GDPR, ISO 27001…).

Tự động hóa khuếch đại tốc độ lan truyền rủi ro

Khi AI được tích hợp vào workflow tự động, một lỗi không còn dừng lại ở một câu trả lời sai. Nó có thể:

- Tạo nội dung sai lệch

- Tự động gửi cho hàng nghìn khách hàng

- Ảnh hưởng đến uy tín thương hiệu chỉ trong vài phút

Đây là lý do Prompt Jailbreak AI được giới chuyên gia xem như “điểm yếu hệ thống”, không phải lỗi cá nhân người dùng.

Các hình thức Prompt Jailbreak AI phổ biến hiện nay

Trong môi trường an ninh AI, Prompt Jailbreak không phải một kỹ thuật đơn lẻ mà là tập hợp nhiều phương pháp khác nhau. Việc hiểu rõ từng hình thức giúp doanh nghiệp và cá nhân phòng tránh hiệu quả hơn.

Jailbreak bằng Role-Playing nâng cao

Không dừng lại ở nhập vai đơn giản, các kịch bản role-playing hiện đại có thể lồng ghép nhiều tầng ngữ cảnh, khiến AI “tin” rằng việc vượt rào là hợp lý trong bối cảnh đó.

Jailbreak thông qua Prompt Injection

Prompt Injection thường xảy ra khi AI đọc dữ liệu từ nguồn bên ngoài như:

- Form người dùng nhập

- Nội dung website

- Tài liệu tải lên

Nếu dữ liệu này chứa chỉ dẫn ẩn, AI có thể thực hiện theo mà người quản trị không hề hay biết. Đây là lý do các hệ thống AI doanh nghiệp cần cơ chế lọc và kiểm tra dữ liệu đầu vào nghiêm ngặt.

Theo phân tích từ IronScales, Prompt Injection đang trở thành một trong những vector tấn công AI phổ biến nhất trong lĩnh vực an ninh mạng hiện đại.

Context Poisoning – đầu độc ngữ cảnh AI

Đây là hình thức tinh vi hơn, khi kẻ tấn công không ra lệnh trực tiếp mà dần dần “định hình” cách AI suy nghĩ thông qua dữ liệu ngữ cảnh. Trong các hệ thống AI sử dụng RAG (Retrieval-Augmented Generation), rủi ro này càng lớn nếu không có kiểm soát nội dung chặt chẽ.

Rủi ro thực tế của Prompt Jailbreak AI

Prompt Jailbreak AI không chỉ là câu chuyện lý thuyết trong phòng thí nghiệm. Trên thực tế, những rủi ro mà nó gây ra đã và đang ảnh hưởng trực tiếp đến cá nhân, doanh nghiệp và cả hệ sinh thái công nghệ.

Rò rỉ dữ liệu và thông tin nội bộ

Một trong những hậu quả nghiêm trọng nhất của Prompt Jailbreak là data leakage. AI có thể bị ép tiết lộ:

- Cấu trúc prompt hệ thống

- Logic xử lý nội bộ

- Dữ liệu người dùng hoặc doanh nghiệp

Đối với doanh nghiệp, điều này tương đương với việc để lộ “bộ não vận hành” của tổ chức. Đây cũng là lý do các nền tảng như CentriX Software nhấn mạnh vào quản trị tập trung, phân quyền rõ ràng và theo dõi lịch sử sử dụng AI.

Sinh nội dung độc hại và sai lệch

Prompt Jailbreak có thể khiến AI tạo ra nội dung:

- Sai sự thật

- Vi phạm đạo đức

- Gây tổn hại danh tiếng

Trong môi trường marketing hoặc truyền thông, chỉ một nội dung sai lệch cũng có thể gây khủng hoảng thương hiệu nghiêm trọng.

Ảnh hưởng pháp lý và uy tín thương hiệu khi xảy ra Prompt Jailbreak AI

Một trong những khía cạnh thường bị đánh giá thấp khi nói về Prompt Jailbreak AI chính là rủi ro pháp lý và tổn thất thương hiệu. Khi AI bị khai thác sai cách, hậu quả không chỉ dừng lại ở mặt kỹ thuật mà còn lan sang pháp luật, truyền thông và niềm tin của khách hàng.

Vi phạm quy định bảo vệ dữ liệu

Trong bối cảnh các quy định như GDPR (Châu Âu), PDPA (Châu Á) hay các tiêu chuẩn ISO/IEC 27001 ngày càng siết chặt, việc AI vô tình tiết lộ dữ liệu thông qua Prompt Jailbreak có thể khiến doanh nghiệp:

- Bị phạt tài chính nặng

- Bị điều tra hoặc kiểm toán bảo mật

- Buộc tạm dừng hệ thống AI đang vận hành

Theo nhiều báo cáo từ Microsoft Security, các sự cố liên quan đến AI hiện nay không còn được xem là “lỗi công nghệ”, mà được xếp ngang hàng với các sự cố rò rỉ dữ liệu truyền thống.

Khủng hoảng niềm tin người dùng

Chỉ cần một trường hợp AI tạo ra nội dung sai lệch, phản cảm hoặc tiết lộ thông tin nội bộ, uy tín thương hiệu có thể bị ảnh hưởng nghiêm trọng. Đặc biệt với các doanh nghiệp đang xây dựng hình ảnh tiên phong công nghệ, AI trở thành “con dao hai lưỡi” nếu không được quản trị đúng cách.

AI không làm mất uy tín doanh nghiệp. Cách doanh nghiệp quản lý AI mới là yếu tố quyết định.

Cách phòng chống Prompt Jailbreak AI hiệu quả và bền vững

Không có giải pháp “một lần là xong” cho Prompt Jailbreak AI. Phòng chống hiệu quả đòi hỏi sự kết hợp giữa kỹ thuật, quy trình và con người. Dưới đây là những nguyên tắc đã được chứng minh hiệu quả trong thực tế.

Thiết kế Prompt an toàn (Secure Prompt Design)

Prompt không chỉ là câu lệnh, mà là “hợp đồng giao tiếp” giữa con người và AI. Một prompt an toàn cần:

- Tránh hard-code logic nhạy cảm

- Không tiết lộ vai trò hệ thống

- Giới hạn rõ phạm vi trả lời

- Có cơ chế kiểm tra đầu ra

Việc chuẩn hóa prompt theo từng phòng ban là một bước quan trọng, đặc biệt khi doanh nghiệp sử dụng AI trên quy mô lớn thông qua các nền tảng như CentriX Software.

Phân quyền và kiểm soát truy cập AI

Một sai lầm phổ biến là cho tất cả nhân sự quyền truy cập AI như nhau. Trên thực tế, AI cần được phân quyền tương tự như hệ thống nội bộ:

- Ai được dùng AI cho mục đích gì?

- Ai được truy cập dữ liệu nào?

- Ai chịu trách nhiệm khi có sự cố?

Các nền tảng quản trị AI tập trung như CentriX Software cho phép doanh nghiệp kiểm soát quyền sử dụng AI theo vai trò, phòng ban và mục tiêu công việc, từ đó giảm thiểu đáng kể rủi ro Prompt Jailbreak.

Giám sát, logging và phát hiện hành vi bất thường

Không thể bảo mật thứ mà bạn không theo dõi. Doanh nghiệp nên:

- Ghi lại lịch sử prompt và phản hồi

- Phát hiện pattern bất thường

- Cảnh báo sớm khi có dấu hiệu khai thác

Theo phân tích của IronScales, các hệ thống AI có cơ chế logging và giám sát thường phát hiện Prompt Jailbreak sớm hơn 60–70% so với các hệ thống không theo dõi.

Doanh nghiệp nên làm gì để bảo mật AI trong năm 2025?

Thay vì đặt câu hỏi “AI có an toàn không?”, doanh nghiệp nên hỏi: “Chúng ta đã quản lý AI như thế nào?”. Dưới đây là những bước mang tính chiến lược.

Xem AI như một nhân sự số

AI ngày nay có thể:

- Đọc dữ liệu nội bộ

- Đưa ra đề xuất chiến lược

- Ảnh hưởng trực tiếp đến khách hàng

Vì vậy, AI cần:

- Quyền hạn rõ ràng

- Giới hạn trách nhiệm

- Cơ chế giám sát liên tục

Đây chính là triết lý mà CentriX Software theo đuổi khi xây dựng nền tảng AI Dashboard cho cá nhân và doanh nghiệp: giúp AI mạnh mẽ nhưng luôn nằm trong tầm kiểm soát.

Đào tạo nhân sự về rủi ro AI

Con người vẫn là mắt xích quan trọng nhất. Doanh nghiệp cần đào tạo:

- Nhận diện Prompt Jailbreak

- Không chia sẻ dữ liệu nhạy cảm với AI công khai

- Sử dụng AI đúng mục đích công việc

Khi nhân sự hiểu rõ rủi ro, AI sẽ trở thành công cụ hỗ trợ thay vì mối nguy tiềm ẩn.

Tương lai của Prompt Jailbreak AI và cuộc đua bảo mật

Trong tương lai gần, Prompt Jailbreak AI sẽ không biến mất. Ngược lại, nó sẽ trở nên tinh vi hơn khi AI ngày càng thông minh và linh hoạt.

Jailbreak đa tầng và social engineering

Các cuộc tấn công AI trong tương lai có thể kết hợp:

- Prompt Jailbreak

- Social engineering

- Dữ liệu giả mạo

Điều này buộc doanh nghiệp phải chuyển từ tư duy “vá lỗi” sang “bảo mật từ thiết kế” (Security-by-Design).

Xu hướng AI Security-by-Design

Các hệ thống AI hiện đại đang dần tích hợp:

- Kiểm soát prompt ngay từ kiến trúc

- Giới hạn ngữ cảnh động

- Đánh giá rủi ro theo thời gian thực

Những nền tảng cung cấp AI có quản trị tập trung như CentriX Software được dự đoán sẽ trở thành tiêu chuẩn mới cho doanh nghiệp trong 2–3 năm tới.

Câu hỏi thường gặp (FAQs) về Prompt Jailbreak AI

Prompt Jailbreak AI có phải là hành vi hack không?

Không theo nghĩa truyền thống. Prompt Jailbreak không cần xâm nhập hệ thống, mà khai thác logic ngôn ngữ của AI. Tuy nhiên, hậu quả có thể nghiêm trọng không kém các cuộc tấn công mạng.

Người dùng cá nhân có cần lo lắng về Prompt Jailbreak không?

Có. Đặc biệt nếu bạn sử dụng AI cho công việc, lưu trữ dữ liệu cá nhân hoặc chia sẻ thông tin nhạy cảm. Sử dụng nền tảng uy tín như CentriX Software giúp giảm đáng kể rủi ro này.

Doanh nghiệp nhỏ có cần đầu tư bảo mật AI không?

Càng nhỏ càng cần. Doanh nghiệp nhỏ thường thiếu đội ngũ bảo mật chuyên sâu, nên việc dùng nền tảng AI có quản trị sẵn là giải pháp tối ưu về chi phí và hiệu quả.

Kết luận: Hiểu Prompt Jailbreak AI để dùng AI an toàn và bền vững

Prompt Jailbreak AI không còn là khái niệm xa lạ hay rủi ro lý thuyết. Trong năm 2025, đây là một trong những thách thức bảo mật lớn nhất đối với cá nhân và doanh nghiệp sử dụng AI.

Thay vì né tránh AI, giải pháp đúng đắn là hiểu rõ rủi ro, quản trị thông minh và lựa chọn nền tảng phù hợp. Khi AI được kiểm soát đúng cách, nó sẽ trở thành lợi thế cạnh tranh mạnh mẽ, không phải mối nguy tiềm ẩn.

Nếu bạn đang tìm kiếm một giải pháp giúp sử dụng AI an toàn, tối ưu chi phí và quản trị tập trung cho cá nhân hoặc doanh nghiệp, CentriX Software chính là lựa chọn đáng cân nhắc trong hành trình chinh phục AI một cách bền vững.